Проведенное в Harmonic Security исследование показало, что при вводе подсказок корпоративные пользователи ИИ-сервисов могут случайно слить конфиденциальные данные.

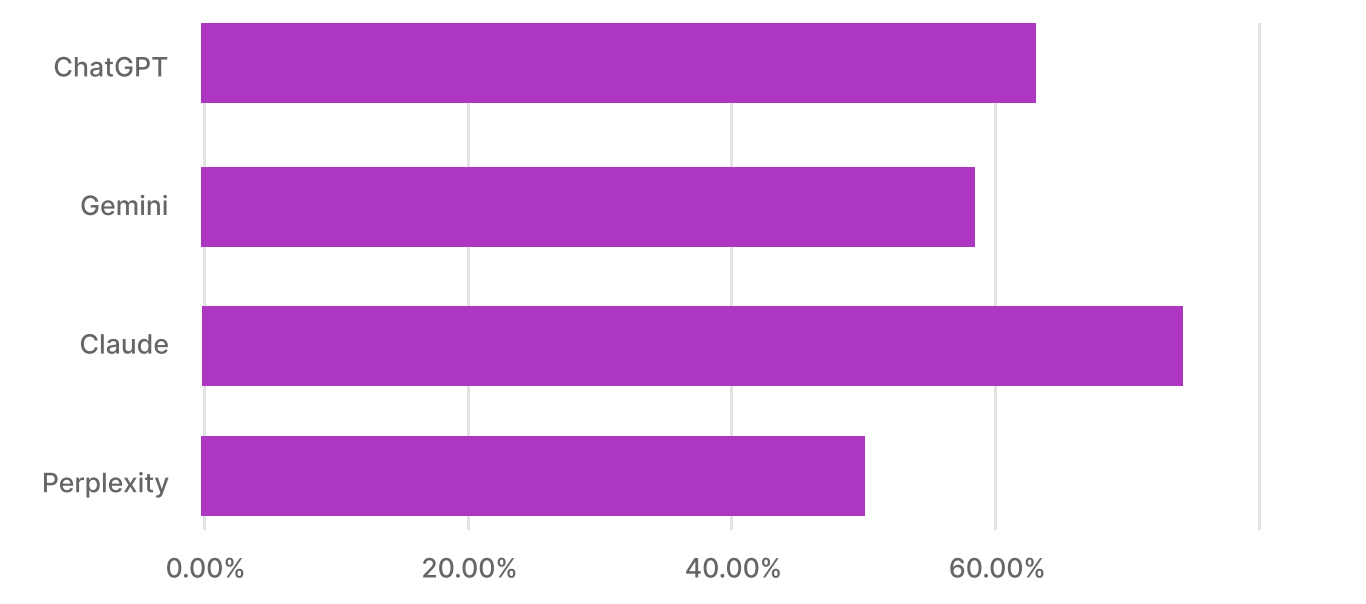

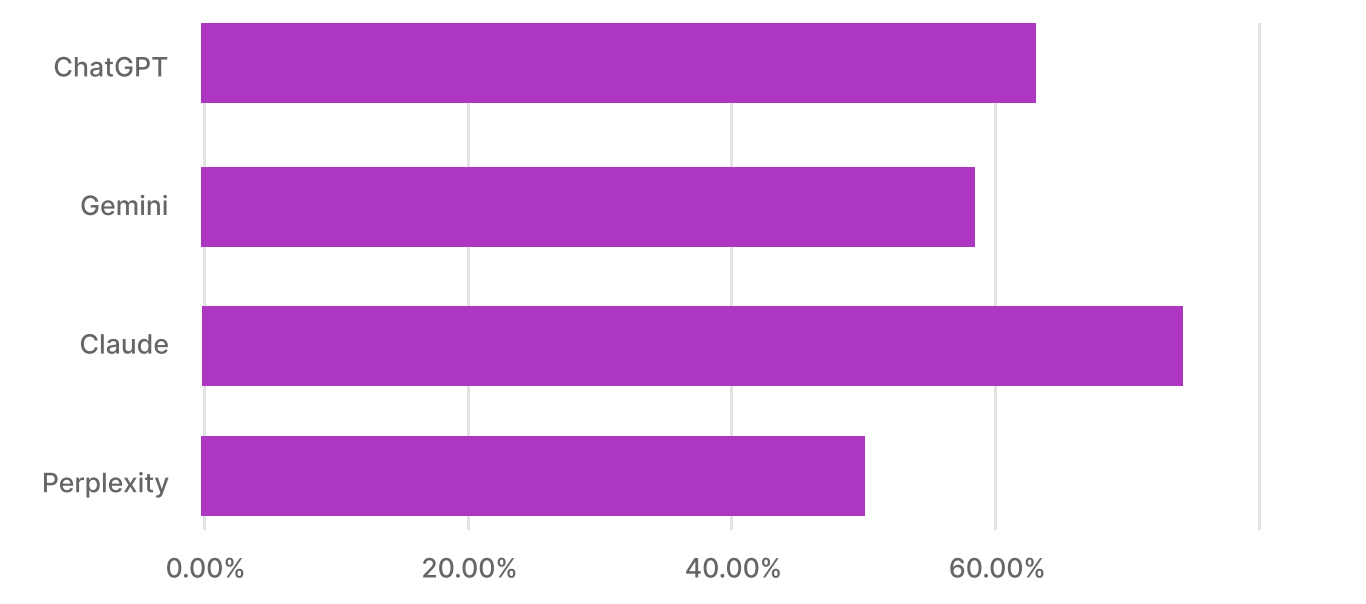

В том числе финансовую информацию, ключи доступа и код проприетарного программного обеспечения. В IV квартале 2024 года эксперты тщательно мониторили использование бизнесом Microsoft Copilot, ChatGPT, Google Gemini, Claude от Anthropic и Perplexity.

За этот период были изучены тысячи посказок-стимулов, которыми сотрудники предприятий пользовались в ходе работы с инструментами на основе генеративного ИИ.

В подавляющем большинстве случаев юзеры решали простые задачи:

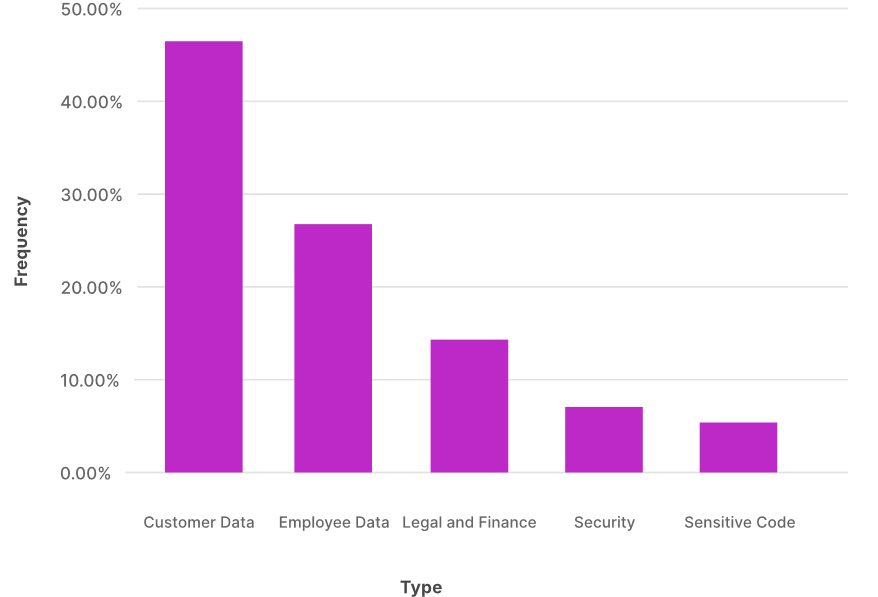

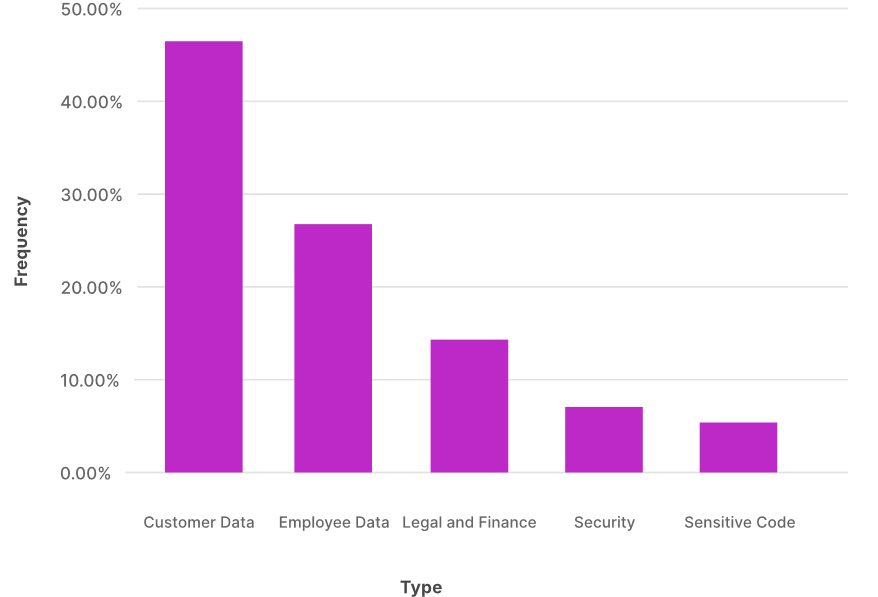

Тем не менее 8,5% зафиксированных подсказок исследователи идентифицировали как угрозу утечки важных данных. В 45,8% случаев такой ввод содержал клиентские данные — сведения об оплате счетов, идентификаторы для доступа к сервисам. Более четверти потенциально опасных подсказок (26,8%) раскрывали информацию о сотрудниках, в том числе расходы по зарплатам, послужные списки, персональные данные.

Умному бизнес-помощнику также могут неумышленно слить юридическую и финансовую информацию (процесс продаж, портфель инвестиций, сделки M&A), связанные с безопасностью сведения (результаты пентестов, конфигурация сети, отчеты об инцидентах), критические важные коды (ключи доступа, исходники проприетарного ПО).

Бесплатные ИИ-инструменты обычно хуже защищены, чем корпоративные версии. К тому же их пользовательское соглашение обычно предусматривает использование пользовательского ввода для тренинга, и риск утечки конфиденциальных данных для бизнеса в этом случае очевиден.

Согласно результатам исследования, сотрудники предприятий отдают предпочтение бесплатным подпискам на ИИ-услуги.

Эксперты не советуют прибегать к блокировкам, чтобы снизить риски. По их мнению, лучше управлять использованием ИИ, придерживаясь следующих рекомендаций:

В том числе финансовую информацию, ключи доступа и код проприетарного программного обеспечения. В IV квартале 2024 года эксперты тщательно мониторили использование бизнесом Microsoft Copilot, ChatGPT, Google Gemini, Claude от Anthropic и Perplexity.

За этот период были изучены тысячи посказок-стимулов, которыми сотрудники предприятий пользовались в ходе работы с инструментами на основе генеративного ИИ.

В подавляющем большинстве случаев юзеры решали простые задачи:

- резюмировали текст,

- редактировали блог-записи,

- оформляли документацию по кодам.

Тем не менее 8,5% зафиксированных подсказок исследователи идентифицировали как угрозу утечки важных данных. В 45,8% случаев такой ввод содержал клиентские данные — сведения об оплате счетов, идентификаторы для доступа к сервисам. Более четверти потенциально опасных подсказок (26,8%) раскрывали информацию о сотрудниках, в том числе расходы по зарплатам, послужные списки, персональные данные.

Умному бизнес-помощнику также могут неумышленно слить юридическую и финансовую информацию (процесс продаж, портфель инвестиций, сделки M&A), связанные с безопасностью сведения (результаты пентестов, конфигурация сети, отчеты об инцидентах), критические важные коды (ключи доступа, исходники проприетарного ПО).

«В большинстве случаев организации справляются с подобным сливом, блокируя запросы либо предупреждая пользователей о потенциальной опасности совершаемых действий, — комментирует гендиректор Harmonic Аластер Патерсон (Alastair Paterson). — Однако не все пока располагают такими возможностями. Беспокоит также большое количество бесплатных подписок».

Бесплатные ИИ-инструменты обычно хуже защищены, чем корпоративные версии. К тому же их пользовательское соглашение обычно предусматривает использование пользовательского ввода для тренинга, и риск утечки конфиденциальных данных для бизнеса в этом случае очевиден.

Согласно результатам исследования, сотрудники предприятий отдают предпочтение бесплатным подпискам на ИИ-услуги.

Эксперты не советуют прибегать к блокировкам, чтобы снизить риски. По их мнению, лучше управлять использованием ИИ, придерживаясь следующих рекомендаций:

- мониторинг ввода данных в реальном времени;

- использование платного доступа либо сервисов, не обучающих свои модели на пользовательском вводе;

- визуальный контроль данных, которыми юзеры делятся с ИИ-инструментами, со стороны ИБ-служб;

- ранжирование конфиденциальных данных по степени ущерба в случае потери;

- создание правил использования ИИ с дифференциацией департаментов и групп;

- обучение персонала ответственному использованию ИИ, с объяснением рисков.

Для просмотра ссылки необходимо нажать

Вход или Регистрация